Yapay Zekâ Denetimi

Önceki yazılarımızda güvenilir yapay zekâya neden ihtiyaç duyduğumuzu ve dünya genelinde güvenilir yapay zekâ için belirlenen ilke ve değerlerin neler olduğunu ele almıştık. Bu yazımızda geliştirilen yapay zekâ sistemlerinin güvenilirliğinden emin olabilmemiz için ihtiyaç duyduğumuz yapay zekâ denetiminden, denetimin çeşitlerinden ve denetim için farklı gruplar tarafından önerilen farklı denetim çeşitlerini ele alacağız.

Yapay zekâ sistemlerinin yönetişimini sağlayabilmek ve bu sistemlerden kaynaklı ortaya çıkabilecek riskleri azaltmak için yapay zekâ sistemlerinin denetimine ihtiyaç vardır. Yapay zekâ veya algoritma denetimi olarak adlandırılan bu denetimin şekil itibarıyla iki türü vardır: iç denetim (birinci taraf denetimi) ve dış denetim (ikinci ve üçüncü taraf denetimleri). İç denetim, şirketin kendi kendine uyguladığı bir denetimdir [1]. Dış denetim, ikinci taraf denetimi veya üçüncü taraf denetimi şeklinde gerçekleştirilebilir. “İkinci taraf denetimleri, müşteriler gibi kuruluşta çıkarı olan taraflar veya onlar adına diğer kişiler tarafından gerçekleştirilirken, üçüncü taraf denetimi, uygunluk belgelendirmesi/tescilini sağlayanlar veya devlet kurumları gibi bağımsız denetim kuruluşları tarafından gerçekleştirilir.” [1]. Dış denetim, AB Genel Veri Koruma Tüzüğü (GVKT) ve yorumları (mesela AB'nin Otomatikleştirilmiş bireysel karar verme ve Profil Oluşturma Yönergeleri) bağlamında tavsiye edilmektedir [2]. AB'nin Güvenilir Yapay Zekâ için Etik İlkeleri denetlenebilirliğin güvenilir yapay zekâ için bir gereklilik olduğuna işaret eder ve bağımsız iç ve dış denetimlerin gerekli olduğunu belirtir [2]. İçerik itibarıyla göze çarpan bir denetim çeşidi ise uygunluk denetimidir. Uygunluk denetimi, bir kuruluşun düzenleyici yönergelere bağlılığının bağımsız bir incelemesidir [3]. Uygunluk denetimini hem iç hem de dış denetim şeklinde yapmak mümkündür.

Yapay zekâ sistemlerinin denetimi için farklı çerçeveler öne sürülmektedir. Bu çerçevelerden birisi yapay zekâ sistemlerinin bağımsız denetimidir. Bu çerçeve, çok disiplinli ve uluslararası bir ekip tarafından “Bağımsız denetimler yoluyla YZ güvenliğini yönetmek” isimli bir makalede yapay zekâ sistemlerinin güvenilirliğini sağlamak için önerilmiştir. Bağımsız denetim mevcut yasaları, yönergeleri ve en iyi uygulamaları uygulanabilir, ölçülebilir, ikili (uyumlu/uyumsuz) denetim kurallarına dönüştürmek için fikir birliğine dayalı, şeffaf ve paydaşları kapsayan bir süreçtir [4]. Bağımsız denetimin üç yönetişim ilkesiyle uyumlu olması beklenmektedir:

“1) İleri düzeyde otomatikleştirilmiş sistemler uygulanmadan önce ileriye dönük değerlendirilmeler,

2) Hataları analiz etmek ve hesap verebilirliğin değerlendirilmesine yardımcı olmak için denetim izi ve

3) Yargı gereksinimlerine sistem bağlılığı” [4].

Sigortacılar, mahkemeler ve devlet kurumları bağımsız denetimin üç potansiyel uygulayıcısıdır [4].

Şimdiye kadar bağımsız denetim yapılmamakla beraber ForHumanity (kâr amacı gütmeyen Amerika merkezli bir kurum) tarafından bağımsız denetim modeli oluşturulmuştur. ForHumanity, mevcut yasaları, yönergeleri ve en iyi uygulamaları şeffaf ve kitle kaynaklı bir şekilde ikili denetim kurallarına dönüştürmüştür [5]. Birleşik Krallık’ın Genel Veri Koruma Tüzüğü ve Yaşa Uygun Tasarım Kodu bunun en iyi örneklerindendir [5]. Kısaca özetlemek gerekirse bağımsız denetim modeli için denetim kurallarının oluşturulması şu şekilde işlemektedir: Yasalar, sürece dâhil olmak isteyen bir grup insan tarafından şeffaf bir şekilde ikili denetim kurallarına dönüştürülmüş ve Birleşik Krallık’ın bağımsız veri otoritesi Bilgi Komisyonu Ofisi’nin onayına gönderilmiştir. Bu süreç yinelenen bir şekilde olmaktadır yani Bilgi Komisyonu Ofisi geri bildirimlerde bulunarak kuralları geri gönderip yeniden düzenlenmesini istemektedir. Denetim kuralları Bilgi Komisyonu Ofisi tarafından kabul edildikten sonra bu kurallara göre bağımsız denetim yapılabilir.

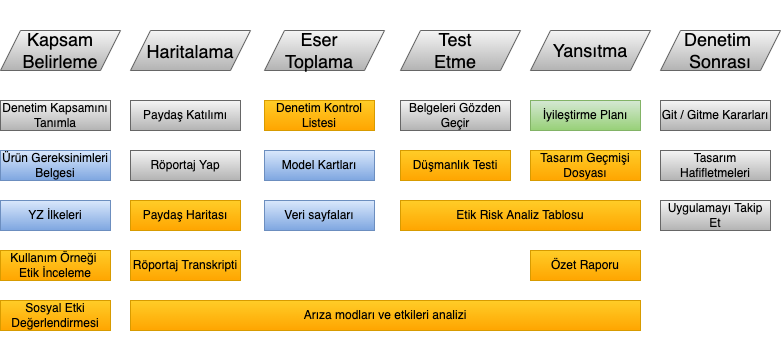

İç denetim için önerilmiş farklı çerçeveler vardır. Bunlardan birisi Google ve Partnership on AI ile ilişkili araştırmacılar tarafından “YZ Hesap Verebilirlik Boşluğunu Kapatmak: İç Algoritmik Denetim için Uçtan Uca Bir Çerçeve Tanımlamak” isimli makalede önerilmiştir. Bu çerçeve, şirketlerin ve mühendislik ekiplerinin yapay zekâ sistemlerini uygulamaya koymadan önce denetlemesine izin verir. Aşağıdaki şekilde gösterildiği üzere çerçeve

“1) Kapsam Belirleme,

2) Haritalama,

3) Artifakt Toplama,

4) Test Etme,

5) Yansıtma ve

6) Denetim Sonrası” olmak üzere altı farklı aşamadan oluşmaktadır [6]:

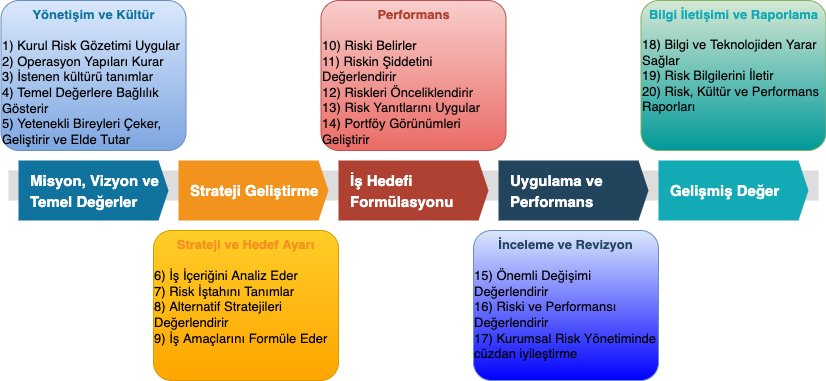

Gri renkler bir süreci belirtirken renkli bölümler denetim kapsamında üretilmesi gereken belgeleri temsil eder. Turuncu renkli belgeler denetçiler tarafından, mavi belgeler mühendislik ve ürün ekipleri tarafından üretilir ve yeşil çıktılar ortaklaşa geliştirilir [6]. İç denetim için önerilmiş bir diğer çerçeve ise Sponsor Kuruluşlar Komitesi (COSO) tarafından önerilen COSO ERM çerçevesidir. Çerçeve, beş bileşenden oluşur:

“1) Yönetişim ve kültür,

2) Strateji ve hedef belirleme,

3) Performans,

4) Gözden geçirme ve revizyon ve

5) Bilgi iletişimi ve raporlama” [7].

Aşağıdaki şekilde görüleceği üzere bu bileşenler 20 ilkeye dayalıdır [7]:

Başka bir çerçeve Genel Veri Koruma Tüzüğü denetimidir. GVKT denetimi bir çeşit uygunluk denetimi olarak düşünülebilir. Bu denetimi hem iç hem de dış denetim olarak yapmak mümkündür. Birçok danışmanlık şirketi dış GVKT denetimi hizmeti sunmaktadır ve birçok kurum tarafından iç GVKT denetimi için GVKT Denetim Kontrol Listesi yayınlanmıştır. Bu listelerden birinin içerdiği genel başlıklar şunlardır: Kişisel veri, Uygulama kapsamı, İşleme için yasal gerekçeler, Şeffaflık gereksinimleri, Diğer veri koruma ilkeleri ve hesap verebilirlik, Veri sahibi hakları, Veri güvenliği, Veri ihlalleri, Uluslararası veri aktarımları, Diğer denetleyici yükümlülükleri, Diğer işlemci yükümlülükleri [8]. Bir başka listede odaklanılan konular ise şöyledir: Yönetişim, Risk yönetim, GVKT projesi, Veri koruma görevlisi, Roller ve sorumluluklar, Uyumluluk kapsamı, Süreç analizi, Mahremiyet bilgi yönetim sistemi, Bilgi güvenliği yönetim sistemi, Veri sahiplerinin hakları [9].

Yazan : Gamze Büşra Kaya

Referans

[1] ISO 19011:2018. 2018. Guidelines for Auditing Management Systems. Standard. International Organization for Standardization.

[2] G. the Supreme Audit Institutions of Finland, “Auditing machine learning algorithms,” 2 Introduction, 24-Nov-2020. [Online]. Available: https://www.auditingalgorithms.net/Introduction.html. [Accessed: 22-Mar-2022].

[3] G. the Supreme Audit Institutions of Finland, “Auditing machine learning algorithms,” Technical terminology, 24-Nov-2020. [Online]. Available: https://www.auditingalgorithms.net/technical-terminology.html. [Accessed: 22-Mar-2022].

[4] G. Falco, B. Shneiderman, J. Badger, R. Carrier, A. Dahbura, D. Danks, M. Eling, A. Goodloe, J. Gupta, C. Hart, M. Jirotka, H. Johnson, C. LaPointe, A. J. Llorens, A. K. Mackworth, C. Maple, S. E. Pálsson, F. Pasquale, A. Winfield, and Z. K. Yeong, “Governing AI safety through independent audits,” Nature Machine Intelligence, vol. 3, no. 7, pp. 566–571, 2021.

[5] R. Carrier, M. Potkewitz, S. Clarke, M. Krebsz, and S. Narayanan, “Comments of ForHumanity In the Matter of Artificial Intelligence Risk Management Framework,” AI RMF RFI Comments - For Humanity. [Online]. Available: https://www.nist.gov/system/files/documents/2021/09/17/ai-rmf-rfi-0107.pdf. [Accessed: 22-Mar-2022].

[6] I. D. Raji, A. Smart, R. N. White, M. Mitchell, T. Gebru, B. Hutchinson, J. Smith-Loud, D. Theron, and P. Barnes, “Closing the AI accountability gap,” Proceedings of the 2020 Conference on Fairness, Accountability, and Transparency, 2020.

[7] “Www.coso.org.” [Online]. Available: https://www.coso.org/Documents/Realize-the-Full-Potential-of-Artificial-Intelligence.pdf. [Accessed: 22-Mar-2022].

[8] “GDPR audit checklist - Taylor Wessing's Global Data Hub,” Home - Taylor Wessing's Global Data Hub. [Online]. Available: https://globaldatahub.taylorwessing.com/article/gdpr-audit-checklist. [Accessed: 22-Mar-2022].

[9] “GDPR compliance audit,” IT Governance. [Online]. Available: https://www.itgovernance.co.uk/gdpr-compliance-audit. [Accessed: 22-Mar-2022].